3 月 9 日,微软德国 CTO Andreas Braun 在一场名为 “AI in Focus - Digital Kickoff” 的活动中表示,GPT-4 将在下周发布,将提供多模态模型。自 3 月初发布 Kosmos-1 以来,微软正在与 OpenAI 微调多模态这一事实应该不再是一个秘密。

此前《财富》杂志曾报道,OpenAI 在 beta 测试版 GPT-4 中采用了更强大的大语言模型,相较前代,GPT-4 可能不会有参数量上的巨幅提升,而是在其他方向寻求提高,“OpenAI 也确实在开发一款通过文字能生成视频的 AI 模型”。

今年 1 月,OpenAI CEO Sam Altman 在回应 “GPT-4 可能拥有 100 万亿参数” 的说法时,称其为“完全是胡说”。这也暗示了即将到来的 GPT-4 不会一味地扩大参数量,而可能向其他方向寻求提升。

“我们将在下周推出 GPT-4,我们将有多模态模型,提供完全不同的可能性——如视频,”Braun 说。这位首席技术官称大型语言模型是 “游戏规则的改变者”,因为它们教机器理解自然语言,然后以统计学方式理解以前只能由人类阅读和理解的内容。同时,该技术已经发展到了基本上 “适用于所有语言” 的程度。“你可以用德语问一个问题,得到意大利语的回答。通过多模态,微软/OpenAI 将 “使模型变得全面”。

此次 GPT4 转向多模态,未来的输入输出将出现图像、视频等形态,或将在业内产生更具颠覆性的影响。OpenAI 此前推出的 DALL-E 2 和 CLIP 便是一次很好的尝试。

近期,微软在多模态方向也动作频频,其推出了全能型人工智能模型——Kosmos-1。与局限于文本内容( LLM)的 ChatGPT 相比,Kosmos-1 属于多模态大型语言模型(MLLM),目前能同时理解文字与图像内容,未来会整合更多的输入模式,如音频、视频。

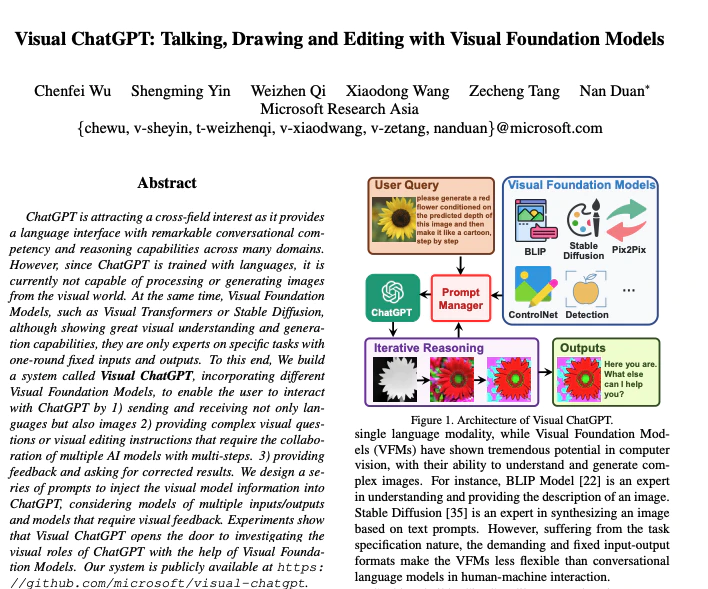

此外,微软也于 3 月 8 日提出了 Visual ChatGPT,其包含不同的视觉基础模型,可以使用户通过以下方式与 ChatGPT 互动:(1)不仅发送和接收语言,而且发送和接收图像;(2)提供复杂的视觉问题或视觉编辑指令,这需要多个人工智能模型的协作和多步骤;(3)提供反馈并要求纠正结果。

微软研究人员在发表于预印本网站 arXiv 上的论文中写道,“ChatGPT 正在吸引跨领域的兴趣,因为它提供的语言界面具有强大的对话能力和在许多领域的推理能力。然而,由于 ChatGPT 是用语言数据来训练的,它目前还不能处理或生成图像。同时,视觉基础模型,如 Visual Transformers 或 Stable Diffusion,虽然显示了强大的视觉理解和生成能力,但它们只是特定任务的“专家”,具有一轮次固定的输入和输出。”

在此次活动中,Braun 和微软德国 CEO Marianne Janik 一起,全面谈到了人工智能对公司的颠覆。Janik 强调了人工智能创造价值的潜力,并谈到了一个时间的转折点——目前的人工智能发展和 ChatGPT 是 “一个 iPhone 时刻”。她说,这并不是要取代工作,而是要以不同于以往的方式完成重复性任务。

颠覆不一定意味着工作的损失。Janik 强调说,“需要许多专家来使人工智能的使用产生价值”。传统的工作正在改变,由于新的丰富的可能性,令人兴奋的新职业正在出现。她建议公司形成内部的 “能力中心”,可以培训员工使用人工智能并形成捆绑式项目创意。在这样做时,“应该考虑到旧宠的迁移”。

Janik 还强调,微软不使用客户的数据来训练模型(然而,根据其 ChatGPT 政策,这一点至少在过去和现在不适用于他们的研究伙伴 OpenAI)。Janik 谈到了 “民主化”——她承认这只是指这些模型在微软产品范围内的直接可用性,特别是通过在 Azure 平台、Outlook 和 Teams 中整合人工智能而广泛使用。

{{item.content}}